Machine Learning Algorithm - linear regression (2)

Algorithms 구성

- Algorithms (1) - Machine learning basic 기초

- Algorithms (2) - Machine learning linear regression (1)

- Algorithms (2) - Machine learning linear regression (2)

- Algorithms (2) - Machine learning linear regression (3)

- Algorithms (2) - Machine learning linear regression (4)

- Algorithms (3) - Machine learning logistic regression (1)

Parameter Estimate Algorithms

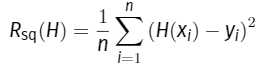

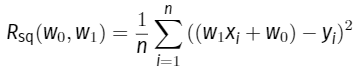

- mean squared error

function H(x)를 w0 + w1 X1으로 두었기 때문에

이런식으로 바뀌게 되는것을 알 수 있다.

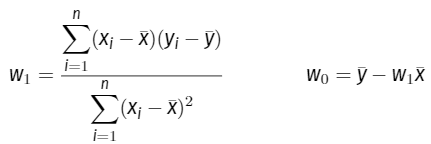

To find best fit line

- cost function을 MSE로 썻기 때문에 parabola 형태를 뛴 그래프 형태가 될 것이다

- gradient descent를 적용 w0과 w1에 대한 partial derivative를 각각 구한다

- partial derivative = 0 꼴로 만들고 w0과 w1으로 풀어쓰게 되면 w0과 w1에 대한 식이 생겨남

^Y = ^w0 + ^w1 X 꼴의 식이 성립된다

Least squared Estimation Algorithm (최소제곱법)

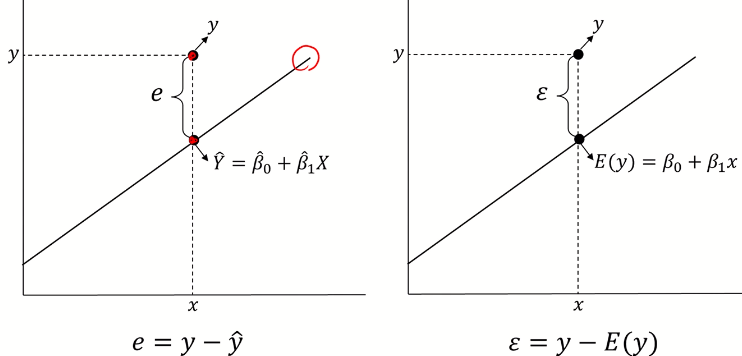

Residual (잔차)

- e = y - ^y 최소 제곱법으로 구해진 직선의 ^Y와 실제 Y값의 차이 (정해진 값)

- ε = y - E(y) 오차항은 확률 분포를 따름

- 잔차 e는 확률 오차 ε이 실제로 구현된 값